¿No tienes ganas de leer? Escucha la versión en audio en inglés.

Introducción

Durante los últimos años, la IA ha captado la atención de muchos sectores, incluyendo el financiero y bancario, donde ha estado ayudando a las instituciones a automatizar numerosos servicios y soluciones importantes. Mientras tanto, la Unión Europea ha dado un paso adelante importante con la introducción de la Ley de IA de la UE.

¿Qué es exactamente la Ley de IA de la UE y por qué importa? En este artículo, le presentaremos los conceptos básicos para proporcionarle una comprensión completa antes de explorar sus implicaciones con más detalle y comprobar la preparación de la IA del sector bancario.

El 56 % de los usuarios agradecería la ayuda de la IA en sus servicios de recomendación financiera, mientras que el 48 % la ve como una herramienta para evaluar solicitudes de crédito o préstamo. Estudio Arizent

¿Qué es la Ley de IA de la UE?

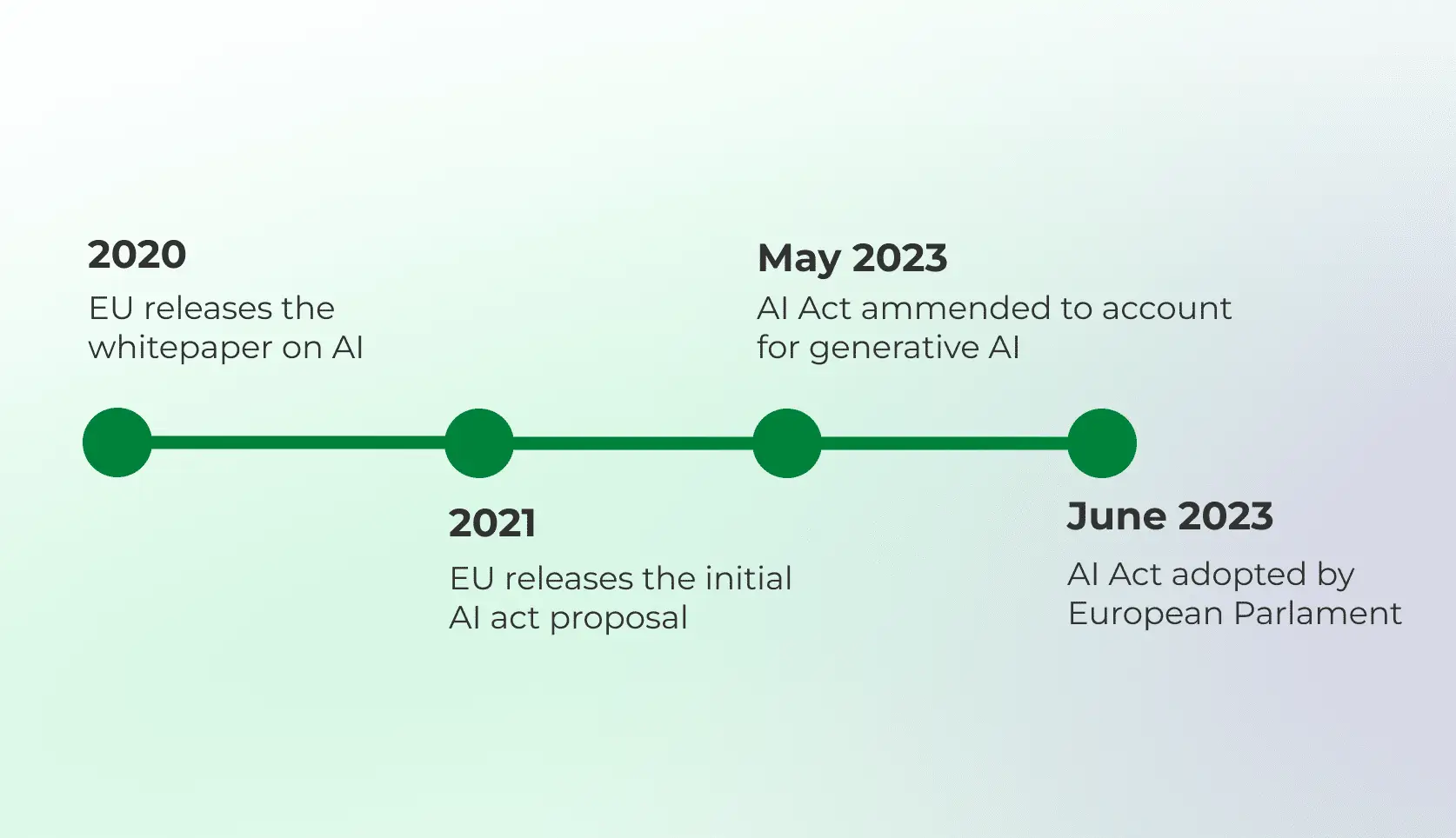

La Ley de IA de la UE es una iniciativa legislativa principal destinada a regular los sistemas de IA dentro de la Unión Europea. Fue introducida por la Comisión Europea y representa un enfoque proactivo para garantizar que las tecnologías de IA se desarrollen y utilicen de manera que se ajusten a los valores y normas reglamentarias de la UE. Se espera que entre en vigor en mayo de 2024, con un período de transición de al menos dos años para su completa implementación.

Además de regular los sistemas de IA para que cumplan con los estándares de seguridad, la Ley de IA tiene como objetivo proteger a los usuarios de los «malos datos». Una de las preocupaciones principales gira en torno al potencial de desinformación perpetuada por los algoritmos de IA Especialmente tras la aparición de contenido generado por IA y de las herramientas que lo procesan, se ha introducido la noción de «alucinaciones»: datos o información mal percibidos y utilizados por los sistemas de IA. La Ley de IA debería salvaguardar este riesgo potencial con requisitos de transparencia y responsabilidad.

El tratamiento de cada plataforma o sistema de IA se basa en un «enfoque horizontal», que sigue una regla muy simple: cuanto mayor sea el riesgo dentro de un sistema de IA determinado, más estrictas serán las regulaciones que deberán aplicarse. Siguiendo esta regla, la Ley de IA se divide aproximadamente en tres niveles de riesgo principales:

Inaceptable: El nivel de riesgo más alto, que será inmediatamente prohibido, incluye los sistemas de IA que fueron o serán creados y mantenidos con un propósito de manipulación, explotación o puntuación social. La mayoría de los sistemas de identificación biométrica a distancia también están incluidos en esta categoría.

Alto riesgo: Los sistemas de IA de esta categoría generalmente incluyen modelos de evaluación crediticia para bancos, gestión y operación de infraestructura crítica, educación, servicios privados esenciales, aplicación de la ley o interpretación y aplicación legal. Estos sistemas deben ser evaluados antes de introducirse en el mercado y también deben ser supervisados durante su ciclo de vida.

Riesgo limitado: El grupo más prominente en el sector de la banca digital, que incluye sistemas que detectan fraudes o mejoran la experiencia del cliente con herramientas como chatbots de atención al cliente, análisis de gastos o gestión de finanzas personales. La IA generativa, como ChatGPT, también se considera de bajo riesgo y debe cumplir con los requisitos de transparencia y la legislación sobre derechos de autor de la UE.

El incumplimiento de prácticas de IA inaceptables o requisitos gubernamentales conllevará multas de hasta 30 millones de euros o el 6 % del total de la facturación global anual, hasta 20 millones de euros o el 4 % de la facturación para sistemas de alto riesgo, y hasta 10 millones de euros o el 2 % de la facturación para sistemas de riesgo limitado.

La Ley trata de establecer normas claras para garantizar la seguridad y fiabilidad de los sistemas de inteligencia artificial de proveedores de la UE y de terceros países. Esto incluye medidas para mitigar los riesgos asociados con la IA, como violaciones de la privacidad de los datos, discriminación y falta de transparencia.

Consejo útil: Entrada y salida de basura explicada: Descubra cómo los chatbots de IA dependen de datos de alta calidad.

Cómo usan los bancos la IA

Chatbots y asistentes de IA: Automatización de la atención al cliente y uso de la IA como asesor financiero personal

Servicios personalizados: Creación de asesoramiento financiero personalizado y experiencias personalizadas dentro del entorno bancario

Detección del fraude: Analizar los patrones de transacción e identificar anomalías que puedan indicar actividades fraudulentas

Puntuación de crédito: Uso de algoritmos de IA para evaluar con precisión el comportamiento y la solvencia del cliente

Automatización: Utilización de la automatización de procesos para mejorar la productividad administrativa y minimizar la carga de trabajo

¿Cómo afecta la Ley de Inteligencia Artificial al sector bancario y qué hacer?

Evaluación del sistema: La Ley enfatiza la importancia de mitigar riesgos donde las decisiones de IA influyen en el acceso de los individuos a los productos financieros. Los bancos y las empresas financieras deben examinar su software e identificar cualquier sistema de IA utilizado en sus procesos de banca digital o automatización Estos sistemas pueden estar sujetos a la Ley de IA y deben ser revisados y clasificados según alguna de las categorías de riesgo.

Cumplimiento de requisitos: Las instituciones financieras deben asegurarse de que sus sistemas de IA cumplan con los requisitos de transparencia y responsabilidad de la Ley. Esto es especialmente importante para los sistemas de alto riesgo, que requieren el más alto nivel de cumplimiento y monitorización. Los sistemas de IA deben proporcionar a los usuarios información clara sobre sus capacidades, limitaciones e impacto potencial.

Gobernanza de datos: Los bancos deben establecer un buen marco interno para los sistemas de IA utilizados dentro de la empresa. La gobernanza de datos efectiva aquí resulta crucial, con una gestión estricta de la calidad de los datos, la privacidad y la seguridad para salvaguardar la información sensible de los clientes y cumplir con los estándares regulatorios como el RGPD.

Supervisión y adaptación: El personal especializado debe ser instruido e informado sobre todos los requisitos de la Ley de IA. En ciertos casos, la Ley requiere supervisión humana de los sistemas de IA para garantizar que las decisiones sean justas, imparciales y estén alineadas con los estándares legales y éticos. Teniendo en cuenta las constantes actualizaciones regulatorias, resulta esencial seguir el estado actual de la Ley de IA y ajustarse en consecuencia.

Conclusión

La Ley de Inteligencia Artificial de la UE representa un hito significativo en la regulación de la inteligencia artificial dentro de la Unión Europea. Mediante el establecimiento de reglas y estándares claros se busca promover el desarrollo y la implementación responsables de tecnologías de IA, mientras se protegen los derechos y valores fundamentales.

En nuestro próximo seminario web, exploraremos la Ley de IA de la UE con más detalle. Sabrá por qué la Ley de IA es importante para los bancos, cómo define los sistemas de IA de alto riesgo o cómo el cumplimiento de la Ley de IA encaja en la estrategia de gestión de riesgos de su banco.